1.3 有监督机器学习回归和分类-逻辑回归-吴恩达

Week3 逻辑回归

1. 二元分类

只有两种可能输出的分类问题称为二元分类。

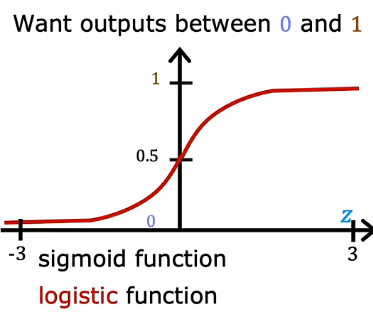

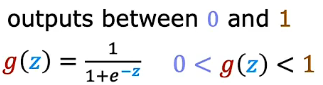

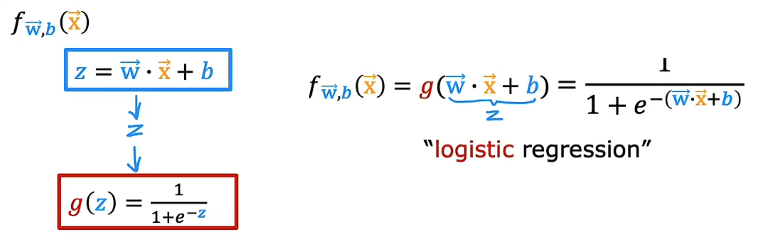

2. sigmoid 函数

输入特征,输出0到1

3. 决策边界

线性or非线性

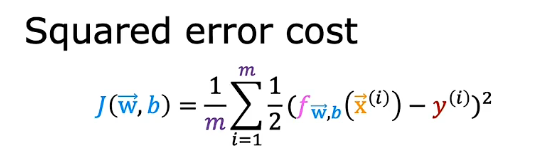

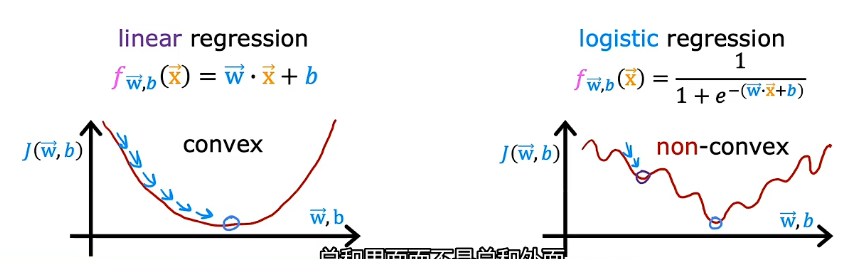

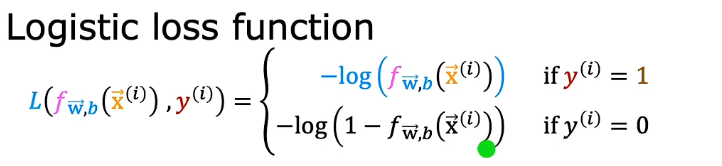

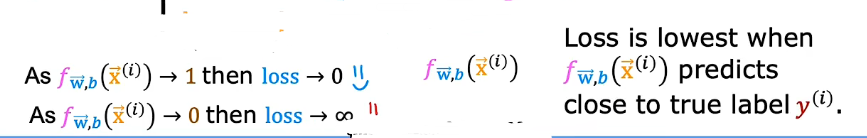

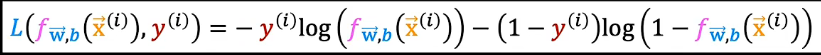

4. 代价函数

平方误差成本函数不是逻辑回归的理想成本函数,常用的是对数损失函数。

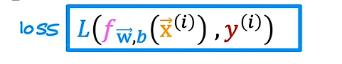

请记住,损失函数衡量的是你在一个训练样例上的表现如何,它是通过总结你随后获得的所有训练样例的损失,成本函数衡量你在整个训练集上的表现。

整体成本函数为凸函数,可以获得全局最小值

简化损失函数

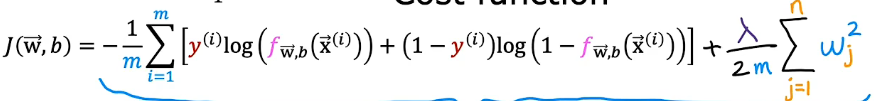

代价函数

使用最大似然估计推导出来,是凸函数。

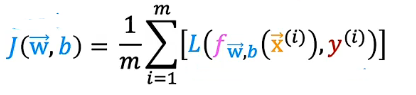

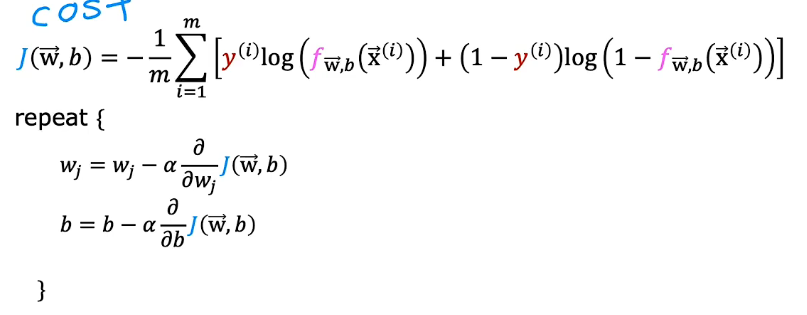

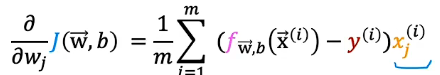

5. 梯度下降

Same concepts:

- Monitor gradient descent(learning curve)

- Vectorized implementation

- Feature scaling

6. 过拟合与欠拟合

欠拟合:高偏差 high bias Does not fit thetraining set well

过拟合:高方差 high variance Fits the training setextremely well

7. 解决过拟合

收集更多的训练样本

选择特征 select features to include/exclude

正则化 Regularization 正则化是一种更温和地减少某些特征影响的方法,而不用像彻底消除它那样严厉。

那么正则化的作用是,它可以让你保留所有特征,但它们只是防止特征产生过大的影响,而这有时会导致过度拟合。

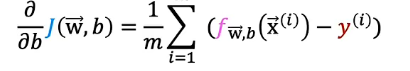

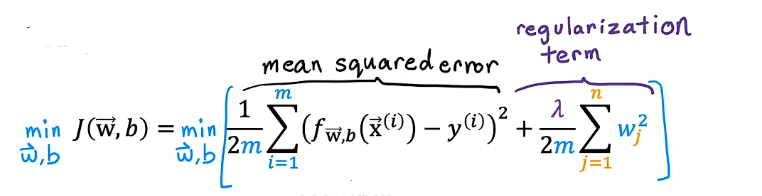

8. 正则化 Regularization

λ正则化参数

正则化线性回归

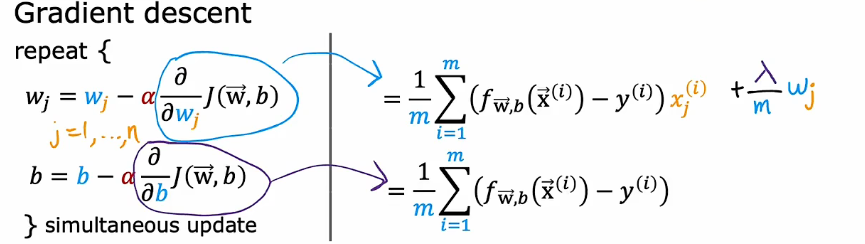

梯度下降

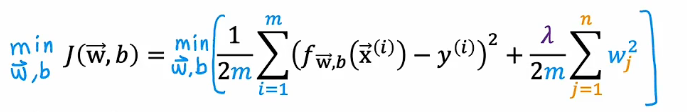

正则化逻辑回归

1.3 有监督机器学习回归和分类-逻辑回归-吴恩达

http://binbo-zappy.github.io/2024/11/13/ML/class1-week3-有监督机器学习回归和分类-逻辑回归/